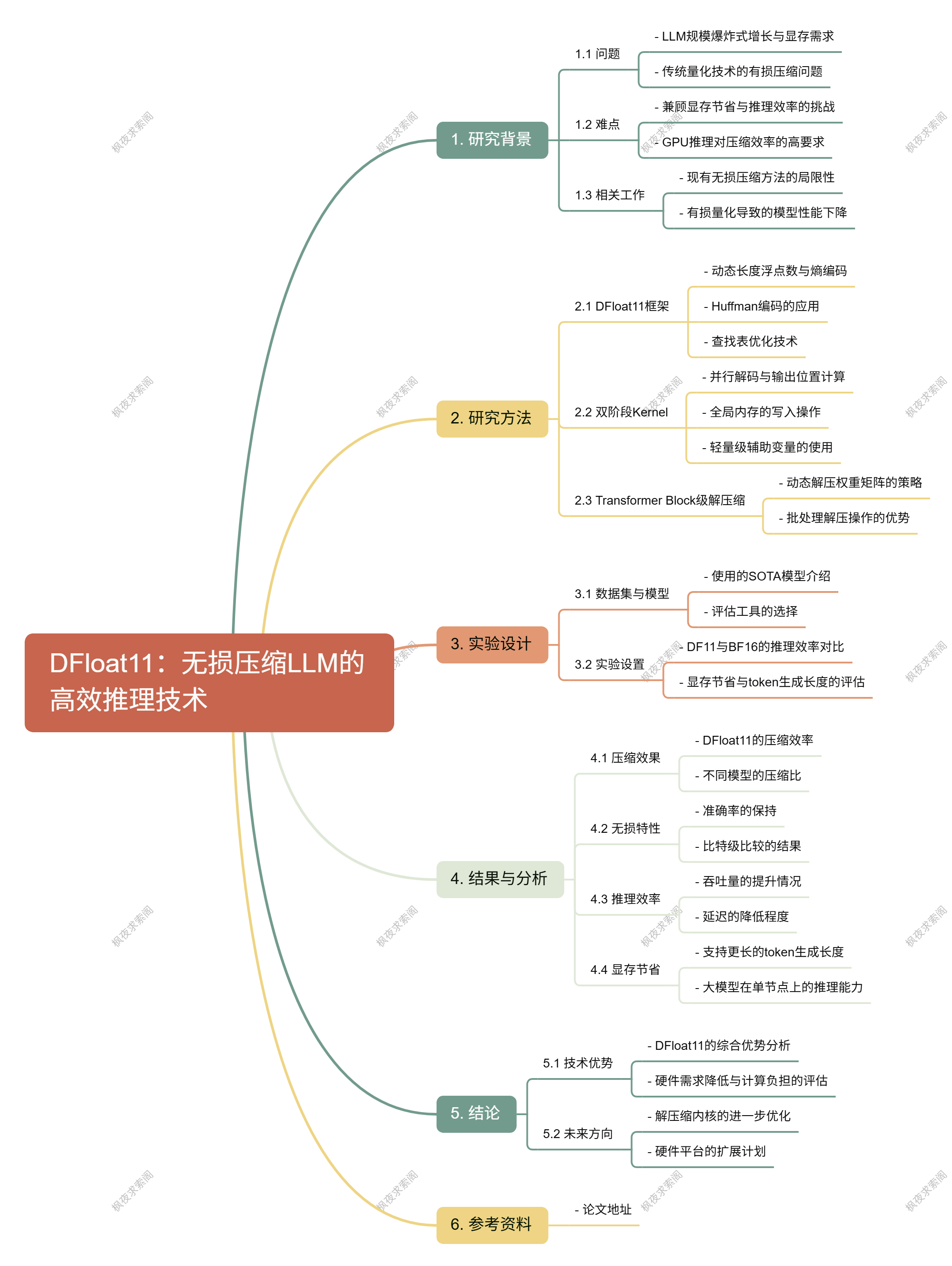

前言

面对LLM模型动辄百GB显存占用、推理速度缓慢、量化压缩导致精度损失的三大难题,莱斯大学提出的DFloat11无损压缩框架实现突破性创新——以动态长度浮点编码技术将模型压缩至70%大小,通过定制GPU内核将推理速度提升最高39倍,同时完全保留原始模型精度(比特级一致),彻底解决传统量化技术牺牲准确性的痛点;更支持单节点运行405B参数大模型(如Llama-3.1),显存占用骤降70%,并允许上下文长度延长5倍以上,显著降低硬件成本与部署门槛,为高精度、高效率的大模型推理提供终极解决方案。

研究背景

- 研究问题: 旨在解决大型语言模型(LLM)在推理过程中对显存需求过高的问题,特别是如何在保证模型输出准确性的前提下,有效压缩模型大小。

- 研究难点: 传统的量化技术虽然能压缩模型,但会牺牲精度,导致模型的准确性和可靠性下降。无损压缩技术虽然能保留原始权重,但在GPU推理效率上存在不足。

- 相关工作: 现有的无损压缩方法主要侧重于提高存储效率,优化训练过程中的检查点回滚和模型下载速度,但在GPU推理方面的优势有限。

研究方法

研究人员提出了一种名为动态长度浮点数(DFloat11)的全新无损压缩框架,能够在不损失精度的情况下将LLM的大小减少30%。具体方法如下:

- 熵编码: 利用香农熵分析LLM线性投影矩阵中参数的信息量,发现指数部分的熵值较低,存在较大的压缩空间。基于此,构建Huffman树对指数部分进行编码,同时保留符号位和尾数。

- 查找表优化: 将内存密集型的查找表(LUT)分解为更紧凑的LUT,使其能够完全放入GPU的SRAM中,从而实现快速访问。

- 双阶段内核: 设计了一个双阶段内核,利用轻量级的辅助变量来协调线程的读写位置,最大限度地降低延迟。

- Transformer Block级解压缩: 在推理过程中,动态地解压缩权重矩阵为原始的BFloat16格式,进行矩阵乘法运算后立即丢弃,以节省GPU显存。

实验设计

实验在多种最新的LLM模型上进行,包括Llama-3.1、Qwen-2.5、Gemma-3等SOTA模型。具体设计如下:

- 数据收集: 使用lm_evaluation_harness工具进行标准基准测试,评估模型的准确率和困惑度。

- 实验设置: 比较DF11压缩模型与未压缩模型在GPU上的推理效率,评估其在不同硬件平台上的表现。

- 样本选择: 选择不同规模的LLM模型进行实验,包括8B、70B等参数量的模型,验证DF11在不同规模模型上的压缩效果。

结果与分析

- 压缩效果: DFloat11将LLM模型的大小压缩至70%,相当于大约11位的有效位宽,所有模型的压缩比约为70%。

- 无损特性: 通过标准基准测试验证,DF11压缩模型的准确率和困惑度与原始BF16模型完全一致,比特级比较也确认两者完全相同。

- 推理效率: DFloat11在推理效率上显著优于CPU卸载方案,延迟降低了1.85至38.83倍,吞吐量提升了1.9到38.8倍。

- 显存节省: DFloat11压缩显著延长了token生成长度,在达到GPU显存限制前能解码5.3到13.17倍的token数量。特别地,Llama-3.1-405B在单节点上实现了无损推理。

总体结论

研究人员提出的动态长度浮点(DFloat)数据格式,特别是DF11,能够在不损失精度的情况下显著减少LLM的显存占用,并兼容高效的GPU推理。实验结果表明,DF11在多个热门LLM上表现出色,显著降低了硬件需求,同时增加了可接受的额外计算负担。